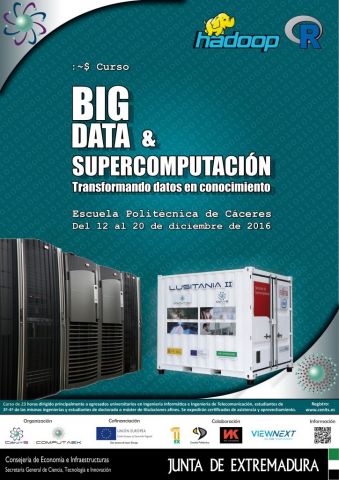

Curso Big Data y Supercomputación. Transformando datos en conocimiento.

El curso "Big Data y Supercomputación: Transformando datos en conocimiento", tendrá lugar del 12 al 20 de diciembre, en horario de tarde, en la Escuela Politécnica de Cáceres. Este curso tiene una duración de 23 horas, y se encuentra dirigido principalmente a egresados universitarios en Ingeniería Informática e Ingeniería de Telecomunicación, estudiantes de 3º y 4º de las mismas ingenierías y estudiantes de doctorado o máster de titulaciones afines.

Se expedirán certificados de asistencia y aprovechamiento. El acceso será libre, aunque limitado a un máximo de 25 alumnos, por lo que se requiere la realización de una inscripción on-line previa.

Horario:

- Lunes 12, martes 13 y miércoles 14: 16:00 a 21:00 horas.

- Jueves 15: 16:00 a 19:00 horas.

- Lunes 19: 16:00 a 21:00 horas.

A continuación se muestra el programa completo del curso:

Bloque 1: Presentación (1 hora)

- Presentación de LUSITANIA I y II.

- Entorno de trabajo.

- Proyectos de la Fundación.

- Introducción a big data y ejemplos para mostrar la problemática del big data.

- Retos al procesar datos big data.

Bloque 2: Supercomputación y framework de Hadoop / Puesta en valor del servicio (9 horas)

- Cloud computing y OpenNebula.

- Hadoop: Justificación y características.

- Módulos básicos del ecosistema de Apache para Hadoop.

- HDFS: Características, arquitectura, rendimiento, configuración, lectura y escritura.

- MapReduce / YARN: Flujo de información y estrategias de definición de map y reduce.

- Práctica: Adición de nuevo nodo al clúster de Hadoop.

- Casos prácticos de recolección de datos para su almacenamiento en el clúster.

- Procesamiento de datos en tiempo real.

Bloque 3: Data Science (10 horas)

- Metodología y buenas prácticas para el procesamiento de datos científicos.

- Programación con R.

- Modelo de programación map / reduce con R.

- Herramientas para la detección de patrones en conjuntos de datos científicos.

- Machine learning: conceptos básicos.

- Implementación de algoritmos de machine learning en Hadoop.

Bloque 4: Casos de éxito con Big Data (3 horas)

- Nuk Consultants: Big Data en el sector turismo.

- ViewNext: Detección de Fraude a la Seguridad Social: Empresas Ficticias.

- CénitS: Aplicación de técnicas Big Data a la predictibilidad del consumo energético. Proyecto ConSumar.

| Adjunto | Tamaño |

|---|---|

| 602.56 KB |